Heft 3/2019 - Netzteil

Es wird Zeit, unseren Maschinen näherzukommen

Interview mit Paul Feigelfeld und Marlies Wirth, den KuratorInnen der Ausstellung Uncanny Values – Künstliche Intelligenz & Du im Rahmen der Vienna Biennale 2019

Die Vienna Biennale For Change 2019 hat sich dem Thema „Schöne neue Werte – unsere digitale Welt gestalten“ verschrieben. Eines der Kernstücke der Biennale ist die Ausstellung Uncanny Values – Künstliche Intelligenz & Du, die sich den vielfältigen Beziehungen des Subjekts zu immer immersiveren, aber auch invasiveren technischen Umgebungen widmet. Im Folgenden erläutern die beiden KuratorInnen Hintergründe, konzeptuelle Ausrichtung und ethische Dimensionen der Schau.

Christa Benzer: Es gibt jeden Tag neue Horrormeldungen über Künstliche Intelligenz. Die Ausstellung ist dagegen weit davon entfernt, ein Angstszenario zu entwerfen. Wieso steht dennoch das Wort „unheimlich“ im Titel?

Marlies Wirth: Uncanny Values ist ein Wortspiel, das auf dem Begriff des Uncanny Valley basiert: ein Konzept des Informatikers Masahiro Mori, das beschreibt, dass wir Menschen Roboter genau so lange niedlich finden, bis sie uns zu ähnlich werden. Dann fällt die statistische Kurve in das sogenannte „unheimliche Tal“. Gleichzeitig referieren wir auf das „Unheimliche“ bei Sigmund Freud (1919). Das Unvertraute im Vertrauten, das beschreibt für uns das Unheimliche an der KI sehr gut – ihre Intelligenz scheint uns menschenähnlich.

Paul Feigelfeld: Wir wollen zeigen, dass nicht die Technologie selbst unheimlich ist, sondern die Wertediskussionen rund um das Thema: der Informationsstand, die Bildungspolitik, die Monetarisierung usw. Wir wollen die Schwachstellen beleuchten, ohne dabei dystopisch zu sein.

Benzer: Ich bleibe noch bei der Psychologie. Im Zusammenhang mit KI wird auch oft von einer Kränkung für uns Menschen gesprochen: Die Maschinen fahren besser Auto und werden vielleicht irgendwann Literaturpreise gewinnen. Was macht man angesichts dieser Situation?

Wirth: Ich habe kürzlich die New York-Dokumentation von Ric Burns wieder gesehen. Er dokumentiert den Beginn des Maschinenzeitalters, das Bauen der Wolkenkratzer, Highways und Brücken etc. Ein Stadtforscher erklärt darin, dass wir Menschen die Landschaft so für uns geformt haben, dass wir sie genießen können – und zwar vom Auto aus. Die Kränkung entsteht, weil damit ein Freiheitsgefühl verbunden war. Ähnlich den Raucherwerbungen. Aus heutiger Sicht ist das alles schlecht. Aber wir werden unsere Werte anpassen müssen, denn irgendwann wird es undenkbar sein, dass ein Mensch alleine ein Gerät besitzt, das die Umwelt verschmutzt, oder überhaupt jeder für sich eine derartige Maschine besitzt, ohne sie zu teilen.

Benzer: Das stimmt fast optimistisch, aber was Künstler wie Trevor Paglen oder James Bridle zutage fördern, ist doch eher besorgniserregend?

Feigelfeld: Diesen Künstlern geht es darum, die Mechanismen und das Potenzial dieser Technologien aufzuzeigen. Derzeit wird ansonsten eher an deren Verschleierung gearbeitet. Was Trevor Paglen oder Contstant Dullaart sichtbar machen, ist der massive technoökonomische Infrastrukturwandel: Alles wird gerade darauf umgestellt, dass jede Google-Anfrage, jedes Facebook-Foto, jeder Instagram-Post, jeder Tweet zu einem Lernprozess beiträgt, der nicht nur zum Wohle der Menschheit dient, sondern auch stark darauf ausgerichtet ist, Profit zu machen.

Benzer: Um welche „Values“ geht es in der Ausstellung?

Wirth: Wir nehmen in der Ausstellung keine Auflistung von Werten vor. Was wir zu bedenken geben, ist die Art, wie Werte transferiert werden: monetäre Werte, aber auch der Wert unseres Planeten, unserer Natur. Es wird oft der Ruf laut, KI sollte zur Beherrschung unserer CO2-Ausstöße eingesetzt werden. Wenn man aber eine KI berechnen ließe, was unserem Planeten schadet, müsste man eine Stadt wie Dubai aufgrund ihres Energieverbrauchs sofort planieren. Das sind schwierige Fragen, die Menschen dort würden sich nicht freuen. Wir möchten ganz allgemein zeigen, dass wir die Wertediskussion besser nicht den Konzernen überlassen: Stichwort Datensicherheit, Krypto-Cyberwar, Selbstparametrisierung …

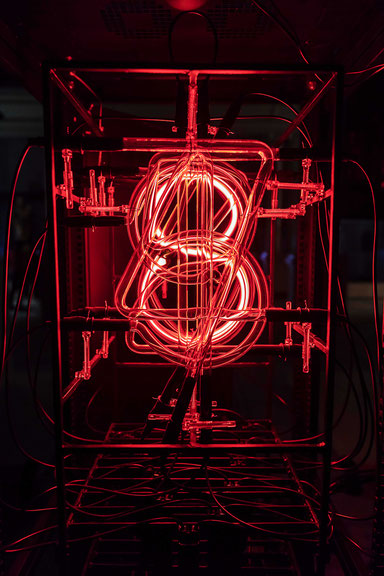

Feigelfeld: Ein gutes Beispiel ist die Arbeit This Much I’m Worth (The self-evaluating artwork) von Rachel Ara. Ihre Maschine berechnet laufend den eigenen Wert und damit gleichzeitig den der Künstlerin, aber auch der Bürgerin und Userin. Genauso wichtig sind in diesem Zusammenhang auch die Arbeiten von Simon Denny, aber natürlich auch von Giulia Bruno und Armin Linke oder James Bridle. Sie stellen genau diese Fragen: Was bedeutet Menschsein, was bedeutet es zu zweifeln, und was bedeutet es, sich selbst zu verstehen? Gleichzeitig ist es unumgänglich, dass wir im evolutionären Miteinander mit den Maschinen diesen näherkommen müssen.

Benzer: Kann man sagen, dass die ethischen Diskussionen gerade wichtiger werden?

Feigelfeld: Zuletzt gab es einen kurzen Hype um ein Ethic Council von Google. Allerdings hat das nur eine Woche gedauert. Das Council wurde wieder aufgelöst, weil man es geschafft hatte, jemanden aus einem rechtsextremen Thinktank hineinzusetzen, dazu nur Männer usw.

Wirth: Eine Ethik der KI muss auch die Bedingungen der Herstellung dieser Technologien miteinbeziehen. Wir zeigen Anatomy of an AI system von Kate Crawford und Vladan Joler. Das Diagramm veranschaulicht, wie ein Amazon Echo hergestellt wird: vom Abbau der seltenen Erden für den Batteriebau bis hin zu seiner sicherheitspolitischen Kontextualisierung. Im Diagramm sieht man, dass der CEO von Amazon auf der Leiter ganz weit oben steht, während ein Minenarbeiter fast nichts kriegt, ganz zu schweigen von den Arbeitsbedingungen in den Fabriken.

Benzer: Wer arbeitet – abgesehen von den KünstlerInnen – derzeit noch an diesen Fragen?

Feigelfeld: Die Einzigen, die die Ressourcen dazu haben, sind natürlich die Industrie und die Regierungen bzw. Geheimdienste. Langsam kristallisieren sich aber auch kleine Inseln von unabhängiger Forschung und Praxis heraus, und die gilt es zu unterstützen. Kate Crawford etwa leitet das AI NOW Institute in New York, ein Forschungsinstitut, das vor zwei Jahren gegründet wurde und auf dem Gebiet gendergerecht, ethnisch divers, smart und unabhängig forscht …

Wirth: … und interessanterweise eine KünstlerInnen-Residency hat. Trevor Paglen und Heather Dewey-Hagborg waren schon dort.

Benzer: Künstliche Intelligenz & Du lautet der Untertitel der Ausstellung. Dass alle davon betroffen sind, ist eine zentrale Aussage der Ausstellung. Hat der Einzelne noch Handlungsmacht?

Feigelfeld: Ich sage ja. Wir müssen globale Handlungsansätze entwickeln, bei denen die Entscheidungen jedes Einzelnen wichtig sind: Das fängt an bei der Partei, die ich wähle, oder welches Produkt ich kaufe, und geht bis zur Software, die ich benutze, oder welche Entscheidung ich treffe bei der Ausbildung meiner Kinder. Da ist noch immer eine riesige Kluft zwischen sowohl nationaler als auch internationaler Politik und dem Technologiesektor. Wir müssen diese Kluft zu schließen versuchen, sowohl individuell als auch im Kollektiv.

Wirth: Genau dazu soll unsere Ausstellung beitragen. So zeigen wir etwa die „AI-Pods“, die von Process Studio mithilfe von Raspberry Pi’s programmiert wurden, konkrete Anwendungen von KI, beispielsweise „AImojis“ (KI-generierte Emojis) oder eine KI-generierte Schriftart. Im Gegensatz zu üblichen PCs handelt es sich bei Raspberry Pi’s um sehr kleine, einfach gebaute Rechner, die das Erlernen von Programmier- und Hardwarekenntnissen erleichtern. Technologie sollte zugänglich gemacht werden. Gerade jüngere Menschen fragen in unseren Ausstellungen immer wieder, ob sie das auch machen können. Dabei geht es um Empowerment, und inzwischen können wir antworten: Ja, ihr könnt euer eigenes neuronales Netzwerk trainieren.

Uncanny Values – Künstliche Intelligenz & Du, MAK Wien, 29. Mai bis 6. Oktober 2019; http://www.viennabiennale.org/