Heft 3/2024 - Netzteil

Der Bedeutung Struktur geben

Wie große Sprachmodelle implizit auf die Theorie des Anthropologen Claude Lévi-Strauss Bezug nehmen

Ungeachtet ihrer Defizite hat der Einfluss von Künstlicher Intelligenz beispiellose Auswirkungen: So stieg in den letzten vier Jahren – parallel zum Weltereignis Pandemie – die Verwendung des von ChatGPT oft genutzten englischen Stilworts „delve“ (dt. „eintauchen“) in wissenschaftlicher Literatur stärker an als die des Wortes „pandemic“.1 Auch jüngste Zahlen von OpenAI weisen auf eine Dominanz globalen Ausmaßes hin: GPT-4o, die neueste Version der Serie, auf der auch ChatGPT basiert, unterstützt nun über 50 Sprachen und soll damit 97 Prozent der Weltbevölkerung abdecken.2 Die Textproduktion solcher Sprachmodelle erfolgt dabei probabilistisch. Der Firmenmitgründer von OpenAI, Ilya Sutskever, erklärt: „Je besser die Vorhersage des nächsten Wortes, desto besser das Verständnis.“3 Aber wovon leitet sich das nächste, unbekannte Wort in einer Sequenz ab? Wie muss natürliche Sprache „verstanden“ werden, damit KI-Modelle sie heute mit solch schillerndem Erfolg verwenden können? Und woher kommt dieses Verständnis?

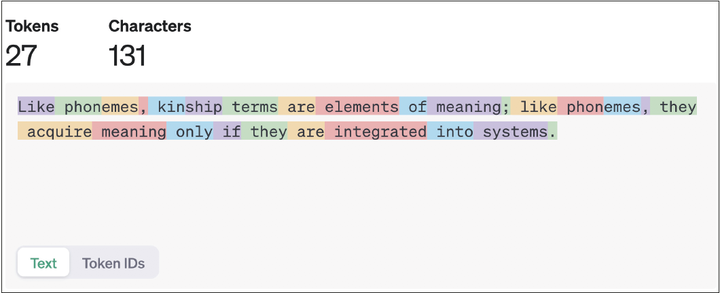

Large Language Models wie ChatGPT werden mittels eines Korpus an Worten trainiert, welche zu sogenannten Token, das sind Wortteile, heruntergebrochen werden. Bei heutigen Modellen sind das etwa fünf bis sechs Billionen Token, die in den Trainingsdaten in unterschiedlichen Sequenzen (Sätzen) auftauchen. Aus all diesen verschiedenen Kontexten werden Beziehungen zwischen den jeweiligen Wortteilen hergestellt. Das Modell wird also nicht darauf trainiert, die Bedeutung eines Wortes (oder Tokens) zu lernen, sondern das Wort im Verhältnis zu allen anderen zu verstehen.4 Die Vorhersage des nächsten Wortes eines Satzes lässt sich demnach nur aus dieser Gesamtheit an Beziehungen gewinnen, das heißt der Sprache als Totalität – oder eben dem Modell davon.

Damit wird hier ein Modell von Sprache bemüht, wie man es schon aus dem Strukturalismus kennt. Begründer der strukturalistischen Linguistik war Ferdinand de Saussure, der 1916 schrieb: „In der Sprache gibt es nur Unterschiede ohne positive Einheiten […] Was ein Zeichen an Inhalt oder an Lautmaterial einschließt, ist viel weniger wichtig als das, was in seinem Umfeld in den anderen Zeichen existiert.“5 Ein Wort existiert also nicht als „positive Einheit“, vielmehr erlangt es seine Bedeutung nur aufgrund seiner Rolle innerhalb der ganzen Struktur einer Sprache.

Die Idee, Bedeutung in einer zugrunde liegenden Struktur zu verorten und diese als Totalität zu betrachten, findet im französischen Anthropologen Claude Lévi-Strauss einen ihrer prominentesten Vertreter*innen. Er war daran interessiert, die vermeintlich universellen Strukturen aufzudecken, wie eine Kultur die Welt um sich herum versteht und klassifiziert.

Dabei entwickelte sich sein Denken ganz maßgeblich unter dem Einfluss der Kybernetik und der Linguistik. Nach erzwungenem Exil in New York las er Anfang der 1950er-Jahre Claude Shannons „Mathematical Theory of Communication“, in der Kommunikation als aus geordneten Elementen bestehend beschrieben wird, die bestimmten Wahrscheinlichkeiten unterliegen. Lévi-Strauss schrieb daraufhin selbst von den „mechanistischen und strukturellen Interpretationsmöglichkeiten“ der Sprache sowie von der „probabilistischen Berechnung“6 ihrer Verwendung.

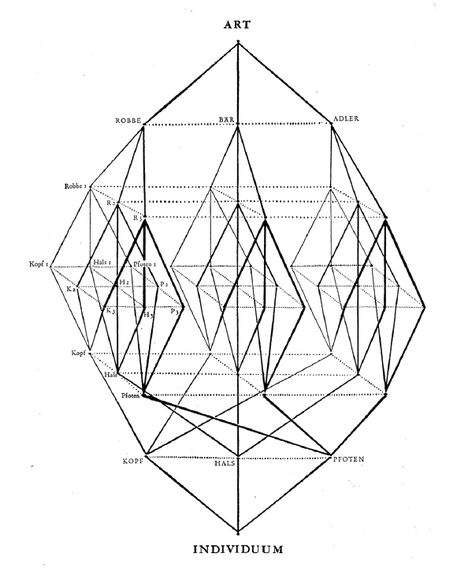

Zudem folgte Lévi-Strauss den Ansätzen der Linguisten Saussure und Roman Jakobson, die Sprache anhand von unterscheidbaren Lauten, den Phonemen, differenzierten.7 Mit Jakobson (den Lévi-Strauss in New York traf) lässt sich das Erlernen von Sprache über einzelne Laute als „computerähnlicher Denkprozeß“ fassen.8 Dazu bedarf es beispielsweise der Unterscheidung in dumpfe und spitze bzw. kompakte und diffuse Vokale, die Lévi-Strauss im Licht von Shannons Theorie als Sets binärer Oppositionen, beschreibbar durch die Informationstheorie, sah. Dies übertrug Lévi-Strauss sogleich auch auf höhere Bedeutungsebenen und Kultur im Allgemeinen.9 Über soziale Beziehungen in Gesellschaften schrieb er: „[W]ie die Phoneme sind die Verwandtschaftsbeziehungen Bedeutungselemente, wie diese bekommen sie ihre Bedeutung nur unter der Bedingung, daß sie sich in Systeme eingliedern.“10 Lévi-Strauss’ Grundgedanke bestand darin, dass, wenn Kulturen Informationen vermitteln können, solche kulturellen Botschaften in einer „algebraischen Struktur“ verschlüsselt sind. Ziel war daher die Aufdeckung einer „semantischen Algebra“, der mathematischen Operationalisierbarkeit von Bedeutung.11 Bei Lévi-Strauss wird so schließlich alles – Sprache, Frauen, Pflanzen, Jagdmethoden und wirtschaftliche Praktiken – als Kommunikationssystem fassbar.12

Als er derlei Ideen 1962 in Das Wilde Denken mit einer Studie der Klassifikationssysteme von vermeintlichen „Wilden“ zu veranschaulichen suchte, fand sich darin auch eine Illustration von Bedeutungsstrukturen als in einem multidimensionalen Beziehungsraum erklärbaren Gebilden. Michael Castelle sieht in heutigen Visualisierungen der von KI gelernten Wortbedeutungen, angeordnet in multidimensionalen Räumen, die Artikulation eines Denkens „analog“ zu dem des Strukturalismus.13 Allerdings war die Konjunktur der Kybernetik zur Zeit des Wilden Denkens schon vorüber, und Lévi-Strauss ging sparsam mit Verweisen auf die Informationstheorie um. Zurück in Frankreich wurde das strukturalistische Projekt zunehmend als Agent eines US-amerikanischen, technokratischen Imperialismus gedeutet, bei dem ein in Maschinen einer westlichen wissenschaftlichen Kultur gefundenes Vorbild universell auf sämtliche Kulturen angewandt wird.14

Dieser Kritikpunkt erscheint im Zusammenhang mit heutigen Sprachmodellen in neuem Licht, bedenkt man die oben angesprochene globale Verbreitung und Anwendung solcher Modelle in Wissenschaft, Politik, Wirtschaft etc. Eine Struktur der Sprache, die ChatGPT und Co. zunächst erlernen sollten, scheint von ihnen auch verändert zu werden. Was damit erneut in den Fokus rückt, ist die akademische Faszination mit einer vermeintlichen „semantischen Algebra“ und damit der Idee, dass, wenn die Datenmengen und Modelle nur groß genug sind, sich dann buchstäblich mit allem „rechnen“ lässt; dass sich also durchgehend latente, mathematische Bedeutungsstrukturen aufdecken lassen – von Sprache, und von Kultur im weitesten Sinne.

[1] Dmitry Kobak et al., Delving into ChatGPT usage in academic writing through excess vocabulary,

arXiv, Juli 2024; http://arxiv.org/abs/2406.07016.

[2] Benj Edwards/Kyle Orland, Major ChatGPT-4o update allows audio-video talks with an „emotional“ AI chatbot, ars technica, 13. Mai 2024; https://arstechnica.com/information-technology/2024/05/chatgpt-4o-lets-you-have-real-time-audio-video-conversations-with-emotional-chatbot/.

[3] Ilya Sutskever, HAI Spring Conference 2022: Foundation Models, YouTube, 28. April 2022 (eigene Übersetzung); https://youtu.be/W-F7chPE9nU.

[4] Leif Weatherby, Capture and Generate: The New Language of AI, YouTube, 9. Mai 2024; https://youtu.be/nUEJNSxg1Tg.

[5] Ferdinand de Saussure, Cours de linguistique générale: zweisprachige Ausgabe französisch-deutsch mit Einleitung, Anmerkungen und Kommentar. Hg. v. Peter Wunderli. Tübingen, 2013, S. 259.

[6] Claude Lévi-Strauss, „The Mathematics of Man“ by Claude Lévi-Strauss, in: Social Analysis 67, Nr. 2 (1. Juni 2023): S. 80–98, hier S. 90 (eigene Übersetzung).

[7] Bernard Dionysius Geoghegan, From Information Theory to French Theory: Jakobson, Lévi-Strauss, and the Cybernetic Apparatus, in: Critical Inquiry 38, Nr. 1 (September 2011), S. 96–126, hier S. 104.

[8] Edmund Leach, Claude Lévi-Strauss zur Einführung. Junius 1998, S. 33ff.

[9] Michael Castelle, Social Theory for Generative Networks (and Vice Versa), 28. September 2018; https://castelle.org/pages/social-theory-for-generative-networks-and-vice-versa.html.

[10] Claude Lévi-Strauss, Strukturale Anthropologie. Berlin: Suhrkamp 1972, S. 46.

[11] Leach, Claude Lévi-Strauss zur Einführung, S. 39.

[12] Geoghegan, From Information Theory to French Theory, S. 123.

[13] Castelle, Social Theory for Generative Networks (and Vice Versa).

[14] Geoghegan, From Information Theory to French Theory, S. 121f.