Heft 4/2020 - Contemporary Artist Writing

Das Raster und der Gradient

Reflexionen über den Platz des Werks in der Welt

Im vorliegenden Text1 möchte ich einige der Überlegungen vorstellen, die mich bei der Entstehung des Werks More Heat than Light begleitet haben. Sie haben womöglich die frustrierende Eigenschaft, dass sie sich zu sehr mit bestimmten Strukturen in der Welt befassen, von denen ich kaum glaube, dass sie der Interpretation von More Heat than Light dienlich sind. Es handelt sich hier um die Betrachtung von Ideen und Hemmnissen, die sich während der Produktion und Distribution des Werks ergeben haben, und, von ein paar Ausnahmen abgesehen, weniger um die Anführung von Gründen, methodischen Ansätzen, Rechtfertigungen oder gar Beschreibungen der Arbeit. Ich möchte mich vielmehr auf eine Konstellation von Konzepten und Formen konzentrieren, mit denen ich es zu tun hatte und bei denen einige Fragen offenblieben. Im Grunde möchte ich diese Konzepte vor allem anhand eines einzelnen Bilds erläutern.

_LIVE FEED ON SCREEN_

Das gezeigte Bild stammt von der Wärmekamera in der Ausstellung. Mein ursprüngliches Interesse daran, diese Kamera zur Dokumentation der Arbeit zu verwenden, beruhte auf der Vermutung, die herkömmliche Installationsdokumentation könnte sich als unbefriedigend erweisen, da die Arbeit unter dem statischen Blick, wie sie Installationsaufnahmen von ausgestellten Werken üblicherweise liefern, besonders leidet. Ich wollte die Unmittelbarkeit, mit der Ausstellungen als Bilder zirkulieren, die einen vermeintlich synoptischen und mehr oder weniger transparenten Zugang zu „dem, was im Raum war“, darstellen, zu einem zentralen Problem der Vermittlung von More Heat than Light machen. Diese Art von Kamera wird nicht nur zur herkömmlichen Sicherheitsüberwachung eingesetzt, sondern auch zur Überwachung der „Kerntemperatur“ in Produktionszusammenhängen, um Einblick in sonst unzugängliche Ebenen möglicher organisatorischer, mechanischer oder anderer Probleme zu bekommen, sei es in einer Fertigungsstraße oder auch in einem Versandzentrum. Sie steht also im Zusammenhang mit einer Ökonomie der Mittel, die den Bedingungen der logistischen Effizienz und des optimalen Funktionierens innerhalb der Produktion und der Zirkulation von Waren den Vorrang einräumt.

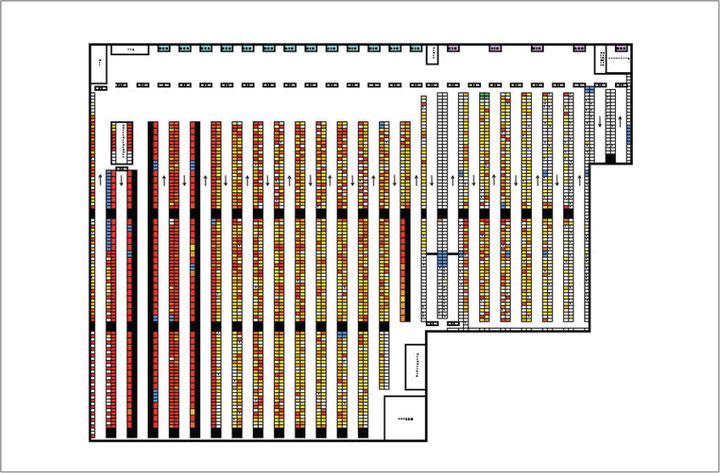

Das gezeigte Bild stammt aus der Broschüre eines Unternehmens, das Produktivitätsbewertungen für Orte wie Vertriebszentren anbietet. Hier handelt es sich um das Kommissionierungssystem2 in einem der Zentren, das analysiert wurde. Bei diesem Service wird eine Wärmekamera wie die in More Heat than Light in der Betriebsstätte platziert, um erfassbare Aktivitäten in Echtzeit aufzuzeichnen. Letztendlich geht es dabei um die Empfehlung von Maßnahmen zur Effizienzverbesserung. Im Grunde „benotet“ das Unternehmen die Leistung der ArbeiterInnen und der technischen Abläufe auf der Ebene der Betriebsorganisation. Das Unternehmen lässt die Kamera bis zu ein Jahr lang laufen, abhängig von den Durchlaufzeiten des jeweiligen Auftraggebers. Die daraus gewonnenen langfristigen Daten werden dann in eine Rasterdarstellung aus Hotspots und nicht genutzten „kalten“ Bereichen des Vertriebs bzw. der Fertigung übersetzt. Diese Daten wiederum werden in ein CAD-Programm importiert, zusammengefasst und übereinandergelegt, um daraus lokale Durchschnittswerte der thermischen Aktivität abzuleiten. Die Mittelwerte werden durch die Farbverläufe dargestellt, die die Wärmebildkamera als Metrum verwendet. Vorgelegt und bewertet wird der gesamte Organisationskomplex aus Körpern, Hardware, die räumliche Darstellung der Regale, das HLSE-System (Heizung, Lüftung, Sanitär etc.). Kurz gesagt, die Daten, die aus dem Prozess der Überwachung und Lokalisierung von Regelmäßigkeiten und bestimmten Tendenzen innerhalb des „Gradienten“ der thermischen Aktivität in der Betriebsstätte gewonnen werden, entstehen dadurch, dass diese Daten in einem Raster dargestellt werden, um dann auf der Grundlage dieses Rasters Planungs- und Effizienzempfehlungen geben zu können.

Es ist durchaus vorstellbar, dass es detailliertere und weniger detaillierte Möglichkeiten zur Darstellung der Mittelwerte in diesem Bild des Kommissionierungssystems gibt. Schließlich sind Raster Strukturen, die Flächen mit unendlich erweiterbaren oder verkleinerbaren Einheiten abbilden. Die Ergebnisse könnten plausibel kompliziert oder vereinfacht werden, zum Beispiel durch zeitliche Verschiebungen, eine weitere Segmentierung des räumlichen Diagramms oder die Berücksichtigung unterschiedlicher Rahmenbedingungen. Dies jedoch erst nach einer Erweiterung oder Verkleinerung des Rasters, das die physische Planung der Regalflächen eines Vertriebszentrums wie dieses oder der schienengeführten Maschinen zum Transport zwischen den Zellen einer Fertigungslinie neu abbildet.

Raster definieren Oberflächen mit scharfen rechtwinkligen Kanten und erzeugen so eine generelle orthogonale Kontinuität. Aber die Definition unterliegt einer Kontrollfunktion. Wie Bernhard Siegert im Hinblick auf die Kulturtechnik des Rasters oder Gitters bemerkt, „besteht dessen hervorstechendstes Merkmal in der Fähigkeit, Prozesse, die auf die Repräsentation von Menschen und Dingen ausgerichtet sind, mit denen der Herrschaft zu verknüpfen“3. Repräsentation und Kontrolle verschmelzen nach Siegert anhand von drei grundlegenden Merkmalen: 1) Körper im dreidimensionalen Raum werden lokalisiert und erhalten eine Adresse, indem sie auf eine zweidimensionale Ebene projiziert werden. 2) Aus der Adresse werden Frachtdaten, so dass diese Daten entsprechend ihrer Platzierung auf der Rasterebene abgerufen und implementiert werden können. 3) Diese funktionelle Platzierung und Speicherung sorgt dafür, so Siegert, dass die „Deixis operationalisiert wird“. Deixis bedeutet die Bindung von Phänomenen an eine kontextuelle Matrix zu Definitionszwecken, wodurch alles, was das Raster lokalisiert – was alles Mögliche zu umfassen scheint –, diesen Prozessen der Platzierung oder des Gestells, der Speicherung und des Abrufs unterworfen wird. Das Raster ist laut Siegert eine mediale Form, die diese Art der kontextuellen Abhängigkeit operationalisiert, in dem Sinne, dass es sowohl die spezifische Adresse –„hier“ oder „dort“ oder „du“ oder „ich“ – liefert als auch den Ort all der anderen „Adressen“ bestimmt, die zur Verständlichkeit des Orts herangezogen werden müssen. Dieses Verständnis von gerastertem Raum folgt einer grundlegend performativen Logik. Das Raster lokalisiert, speichert, reguliert und kontrolliert die Phänomene – und beherrscht dabei die Bedingungen seines eigenen Diskurses, den es überhaupt erst geschaffen hat.

Ein Gradient wiederum ist, physikalisch gesehen, vor allem durch einen extrem detaillierten Übergang zwischen verschiedenen Eigenschaften definiert. Die Vielfalt oder Homogenität dieser Eigenschaften hängt von einer bereits erfolgten Erfassung der Umgebungsbedingungen ab, wie zum Beispiel volumetrische und dimensionale Masse, Viskosität, Umgebungs- und spezifische Formen der Materialbeständigkeit wie der Wärmeleitfähigkeit von Glas im Vergleich zu einem Metall, oder der Bestimmung von Konvektion und Luftstrom. (Dies funktioniert natürlich auch für Informationen, bei denen Berechnungen, die auf eingeschränkten, aber im Wesentlichen nicht vorhersagbaren Datensätzen basieren, als Wahrscheinlichkeitsgradient für verschiedene Arten von Verhalten oder Handlungen herangezogen werden, beispielsweise Materialitäten, bei denen die genaue Adresse oder Standortinformation fehlt. GlücksspielerInnen, die Karten zählen können, verwenden diese Art von Wahrscheinlichkeitsrechnung.) Die einfachste Definition eines Gradienten ist die einer Differenz, die über eine bestimmte Entfernung gemessen werden kann. Wenn dies zutrifft, so lässt sich sagen, dass die Differenz in Intensitätsgraden besteht, im Gegensatz zu Kontrollskalen, wie sie bei gerasterten Räumen angewendet werden. Gradienten hängen im Wesentlichen von materiellen Intensitäten ab, die auch oder gerade weil ihre Ränder an Übertragungen und Verschiebungen beteiligt sind, ein Maß an Besonderheit aufweisen. Die thermische Masse eines Beton- oder Eichenfußbodens beschleunigt oder verlangsamt beispielsweise die Temperatur von überdimensionierten Heizspiralen, weil sie Wärme auf verschiedenen Materialebenen weiterleitet, was durch den Wärmeverlust in die Kältesenke des Raums zusätzlich kompliziert wird. Im Allgemeinen besteht zwischen dem Raster und dem Gradienten eigentlich keine Dialektik – aber zumindest eine Art Vermittlung, eine Abhängigkeit zwischen der intensiven Kollision bestimmter Strukturen des Gradienten und der totalisierenden Matrix des Rasters, die es erlaubt, die Elemente der Gradierung zu lokalisieren, zu beherrschen und zu regulieren. Die Wärmekamera zum Beispiel zeigt einen Temperaturgradienten, doch der digitale Sensor, der diesen für den menschlichen Wahrnehmungsapparat sichtbar macht, ist ganz und gar das Produkt eines Netzes, das über seinen Brennweitenbereich gelegt wurde, formatiert und segmentiert für die XY-Achsen eines Bildschirmbilds.

Ein Raster gibt einen Ort vor, während ein Grad einen Vorgang beschreibt.

_____

Während die Bedingungen für das Erscheinen eines Subjekts im performativen Raum eines Rasters lokalisiert werden können – dem darin ein Ort zugewiesen wird –, haben Gradienten ihre eigene Entstehungslogik. Oder um genauer zu sein: Die Reduktion von Gradienten durch entropische Prozesse ist nach den Erkenntnissen der Physik die Ursache dafür, dass Individuen mit differenzierten Konturen aus zirkulierenden Energien innerhalb sogenannter Nichtgleichgewichts- oder dissipativer Systeme hervorgehen.

Bei Entropieprozessen geht es um Gradientenreduktion. Die zeitgenössische Thermodynamik hat im Zusammenhang mit der Ökologie des späten 20. Jahrhunderts folgende Behauptung aufgestellt: Die Natur verabscheut nicht das Vakuum, sie verabscheut den Gradienten.4 Der zweite Hauptsatz der Thermodynamik, das Gesetz der Entropie, wird durch diese abgestufte Sicht verkompliziert und erweitert. Es geht nicht so sehr um die unvermeidliche Desorganisation und Diffusion relativ geschlossener mechanischer Strukturen – wie zum Beispiel Wärmekraftmaschinen und Warmhaltetische aus dem 19. Jahrhundert oder die statistisch definierte Bewegung von Gasmolekülen als Modell für den planetaren Wärmetod; wichtig ist auch nicht die diffuse Desorganisation zuvor geordneter Zustände, sondern vielmehr die Entstehung einer Ordnung, die auftritt, wenn ein systemischer Zusammenbruch und Unordnung zu höheren, komplexeren Organisationsebenen führen. Dies wird im sogenannten vierten Hauptsatz der Thermodynamik aufgelöst, der auf den Arbeiten von Rod Swenson Ende der 1980er-Jahre beruht. Er wird auch als das Gesetz der maximalen Entropieproduktion (Law of Maximum Entropy Production, LMEP) bezeichnet. Dessen Prinzip wird von Swenson in sehr grundlegenden Begriffen unter der Überschrift „LMEP or Why the World is in the Order Production Business“ beschrieben:

„Stellen Sie sich ein aus dem Gleichgewicht geratenes System mit mehreren verfügbaren Wegen vor, beispielsweise eine beheizte Hütte inmitten eines verschneiten Waldes […]. In diesem Fall erzeugt das System Strömungen durch die Wände, die Ritzen unter den Fenstern und der Tür usw., um das Potenzial zu minimieren. Was wir alle intuitiv wissen (der Grund, warum wir Türen und Fenster im Winter geschlossen halten), ist, dass sich das System immer dann, wenn eine Beschränkung aufgehoben wird, um die Möglichkeit für einen erhöhten Durchfluss zu schaffen, so umkonfiguriert, dass es diesem Pfad mehr Durchfluss zuweist und dasjenige, was dieser nicht aufnehmen kann, den weniger effizienten oder langsameren Wegen überlässt. Kurz gesagt: Unabhängig davon, wie das System angeordnet ist, wird das erzeugte Flussmuster dasjenige sein, das das Potenzial unter Berücksichtigung der Einschränkungen am schnellsten minimiert.“5

Dieser vierte Hauptsatz versucht eine Antwort auf die Frage zu geben, warum geordnete Energieflüsse scheinbar immer wieder genau dort entstehen, wo Ordnung eigentlich zerstört werden sollte: nämlich dort, wo die Dissipation von Energie stattfindet. Die Physik gibt darauf die opportunistische Antwort, der zufolge dem Gesetz der Energiediffusion über längere Zeit hinweg nicht einfach durch Rückkopplungsschleifen (Kybernetik) oder durch negentropische, sich auf ein temporäres Gleichgewicht einpendelnde Prozesse entgegengewirkt wird. Vielmehr sagt das Gesetz der maximalen Entropieproduktion, dass Energie den effizientesten und günstigsten Weg zur Dissipation nimmt. Es postuliert, dass der Weg selbst die Organisationsform ist, die aus der Tendenz zur Unordnung entsteht. Der Weg wird opportunistisch gebildet – auf dem Rücken anderer Umweltfaktoren – und dann nach und nach bestimmt. In ökologischer Hinsicht soll dies die massive, nicht im Gleichgewicht befindliche Komplexität der Natur erklären. Swenson dazu: „Aus ökologischer Sicht […] sind wir Produkte (Ordnung) einer Welt, die durch ihre Produktionen (Ordnung) noch mehr Ordnung (Produktionen) produziert […] Die globale Evolution ist ein erkenntnistheoretischer Prozess, bei dem eine neue Ordnung produziert wird, indem dissipative Dynamiken an neue makroskopische Invarianten höherer Ordnung gekoppelt werden.“6

Ich verstehe das Wissenschaftliche hier selbst nur in Ansätzen. Mein Interesse besteht auch nicht darin, positivistische Beschreibungen von Emergenz zu liefern. Ich beschreibe meine Arbeit nicht in wissenschaftlichen Begriffen, und meine Arbeit verwendet diese Begriffe auch nicht, um andere Phänomene zu beschreiben. Sie erhebt nicht den Anspruch, wissenschaftlich zu sein oder sich mit wissenschaftlichen Erkenntnissen zu befassen. Aber mich interessiert die Art und Weise, in der die Konzepte und die Sprache, die den Raum der wissenschaftlichen Darlegung strukturieren, an einen historischen Kern gebunden sind, der in andere Anwendungs- und Erfahrungsbereiche hineinreicht. Catherine Malabou hat diese Verbindung im Zusammenhang mit der historischen Gleichzeitigkeit von dezentralisierten Formen neoliberaler Kontrolle und dem zunehmend dezentralisierten Bild der neuronalen Funktionsweise in der fortgeschrittenen Neurowissenschaft herausgestrichen. Unter Verweis auf Luc Boltanski und Ève Chiapello liefert sie eine schöne Beschreibung dieser Art von repräsentativer Konvergenz:

„Auf diese Weise werden die kapitalistischen Produktionsformen in jeder Epoche Teil der Repräsentation, indem Konzepte und Instrumente in den Vordergrund treten, die ursprünglich weitgehend autonom im theoretischen Bereich oder im Bereich der wissenschaftlichen Grundlagenforschung entwickelt wurden […] In der Vergangenheit galt dies für Begriffe wie System, Struktur, Technostruktur, Energie, Entropie, Evolution, Dynamik und exponentielles Wachstum.“7

Was WissenschaftlerInnen ursprünglich zur wissenschaftlichen Beschreibung dient, wird zur präskriptiven Domäne, wie die Dinge funktionieren sollten, weil sie dem neuesten wissenschaftlichen Bild der Natur zu entsprechen scheinen. Die Betonung von Emergenz auf der Basis von Gradientenreduktion oder von spontaner Ordnung aus der Effizienz entropischer Prozesse könnte auf eine vertraute Organisationsform sozialer Produktion und Zirkulation hindeuten, die an opportunistische Effizienzmaßnahmen auf Basis komplexer systemischer Vernetzung gebunden ist.

Die Effizienzmaximierung ist im Bereich der Produktion nichts Neues. Sie bildet den Grundimpuls relativer wie absoluter Formen der Wertschöpfung. So wird Effizienz beispielsweise im Hinblick auf die Ausbeutung der Arbeit in der Warenproduktion zu einer Art Codewort, um entweder die Produktionszeit zu maximieren – indem die Arbeitszeit verlängert wird, um die prognostizierten durchschnittlichen Gewinnraten zu erreichen – oder um die Automatisierung des Produktionsprozesses selbst durch neue Technologien zu intensivieren und so den Ertrag und die Durchlaufzeit der Produktion sowie des Umlaufs von Waren zu beschleunigen.

Das vielleicht klassischste Beispiel für Effizienzplanung findet sich in der „tayloristischen“ Organisation der Fabrikhalle. Hier wird die Gestik optimiert, um einen zunehmend mechanisierten Arbeitsprozess von „verschwendeten“ oder „überflüssigen“ Gesten zu bereinigen. In diesem Beispiel ist die Regulierung der Produktionszeit noch immer an einen physischen, arbeitenden Körper gebunden – einen Körper, dessen Kräfte innerhalb des Produktionsprozesses insofern als Kapital erscheinen, als sie mit den Werkzeugen und Materialien, an denen sie arbeiten, einen geschlossenen Kreislauf bilden. Dies impliziert, dass die Handhabung von Material und Werkzeug innerhalb der Produktion schon vorab als Mittel der Selbstverwertung bestimmt ist.

Doch dieser altmodische tayloristische Ansatz zur Bewegungs- und Effizienzplanung (das Werkzeug so anheben, die Kurbel so drehen usw.) weitet sich immer mehr von der eigentlichen Produktion auf die logistischen Realitäten der vernetzten Zirkulation aus, wo globale Standards auf lokale Sachzwänge treffen, die ein komplexes Echtzeitmanagement erfordern, wie es im Managerjargon heißt. In der thermischen Analyse des Vertriebszentrums weicht die Bewegungsplanung in Form der Reduzierung individueller gestischer Atome immer mehr der Planung effizienterer Wege auf einer höheren Organisationsebene. Es geht um die totale Umgebungskontrolle innerhalb einer umfassenderen „Ökologie“ kontrollierter Umgebungen. Ziel ist es, den „Gradienten reduziert“ zu halten, potenzielle bewegungs- und energieintensive Muster innerhalb einer bestimmten Umgebung für die Planung von einem stromlinienförmigen Weg zum nächsten – von einem Kommissionierungssystem zum nächsten – nach Möglichkeit zu eliminieren. Das Kommissionierungssystem eines Vertriebszentrums ist ein Knotenpunkt in einer äußerst komplexen Lieferkette. Die Rolle der Effizienz in den Umlaufzeiten der Zirkulation beruht weitgehend auf der Verknüpfung der Systemüberwachung in der Logistik mit der damit verbundenen Kostenanalyse bei der Berechnung etwa von Energiepreisen, die an die spontane Ideologie der Finanzmärkte gekoppelt sind.

Aus diesem Grund sind Unternehmen wie Amazon so stark auf die Ausweitung der kamerabasierten Bewegungserkennung (Robot Vision) und Bewegungsplanung fokussiert, die algorithmischen, auf optimale Pfadberechnung abzielenden Strukturen wie den sogenannten „Sichtbarkeitsgraphen“ folgt – ganz zu schweigen von der Abschaffung von Lohnverhandlungen und der Möglichkeit der ArbeitnehmerInnen, sich über miserable Arbeitsbedingungen zu beschweren. Amazon ist kein willkürlich gewähltes Beispiel, da das Unternehmen der größte und fortgeschrittenste Nutzer von Echtzeit-Trackingsystemen ist. Dazu gehören Maschinen, die das Verpackungsgewicht messen und beurteilen, ob die PackerInnen die Kartons „auf die eine beste Art und Weise“ beladen haben, wie ein Artikel auf Salon berichtet.8 Das tayloristische Management des Energieverbrauchs in der Arbeitswelt ist in Teilaufgaben unterteilt, bei denen die Bewegung, Lagerung und Verpackung von Waren an sekundengenauen Aufgabenfristen gemessen wird. Dazu gehört auch die Überprüfung der Organisation von Toilettenpausen durch die Manager, da diese Teil der physischen Organisation der Betriebsstätte sind, die es ermöglicht – wie Salon ebenfalls berichtet –, MitarbeiterInnen zu entlassen, wenn diese den am wenigsten effizienten Weg zur Toilette nehmen. Der „eine beste Weg“ ist das Organisationsmotto des Arbeitsmanagements, wobei „Weg“ nicht einfach Methode im Sinne von „Art und Weise“, sondern „Pfad“ im Sinne von physischer Leitung beschreibt. Der Manager wird so zu einem Maxwell’schen Dämonen. Er sieht ständig sogenannte „Prozessabbilder“ wie das hier gezeigte Kommissionierungssystem durch, die aus dem Monitoring von potenzieller Verschwendung in der Fertigungslinie stammen und als Grundlage für die kontinuierliche opportunistische Rationalisierung des effizientesten Wegs zur Aufgabenorganisation dienen. Kontinuierliche Rationalisierung bedeutet, ständig Hemmnisse abzubauen und damit den Gradienten möglicher Aktionen immer effektiver zu reduzieren – so dass eine neue, effizientere Arbeitsordnung entsteht, indem die anvisierten Zeiten für einzelne Aufgaben verkürzt werden, was wiederum die organische Zusammensetzung der Arbeit auf eine unmenschliche Zeitlichkeit zurückwirft.

_____

Es ist also offensichtlich, dass ich Raster und Gradienten nicht einfach als formale Tropen betrachte, die es zu analysieren gilt. Vielmehr möchte ich die Verbindung zwischen dem Raster und dem Gradienten als paradigmatische – insbesondere mediale – Bestimmung der Entfaltung und Analyse einer bestimmten Weltanschauung verstehen. Mit anderen Worten: Die Vermittlung zwischen dem Raster und dem Gradienten ist eine produktive Vermittlung. Und das bedeutet, dass aus Gradienten hervorgehende Raster alles in allem eine epistemische Herangehensweise an die Frage darstellen, wie die soziale Produktion organisiert ist.

Was den unmittelbaren Kontext angeht, in dem ich selbst tätig bin: Kunstwerke, die von Institution zu Institution, von Galerie zu Biennale zu Messe transportiert werden, unterliegen ebenso der beschleunigten Geschwindigkeit des systemischen Beziehungsgeflechts vom Kurs der Schiffe, die die Kisten transportieren, über die Lagerhalle, in der sie gelagert werden, bis hin zur Karte/App auf meinem Telefon, die mich durch einen neuen oder vage erinnerten Stadtplan stolpern lässt. Ich möchte daher die Frage aufwerfen, ob der Rückbezug der Kategorien zurück auf jenen Kontext, zu dessen Kontrolle sie ersonnen worden sind, das Potenzial einer kritischen methodologischen Haltung in sich bergen könnte.

Doch wo lässt sich diese Haltung verorten, wenn es um die Distribution von Kunstwerken geht?

Das historische Projekt der Ortsspezifität, das sich in den 1960er- und 1970er-Jahren über mehrere Generationen hinweg entwickelt hat, kann meines Erachtens zu Recht als ein unwiderruflicher Versuch charakterisiert werden, die ideologische Illusion der Autonomie gegenüber der sozialen, wirtschaftlichen, politischen und geografischen Verankerung von Kunst aufzuheben. Diese Verortung der realen Produktions- und Distributionsbedingungen scheint jedoch zum vollwertigen Projekt institutioneller Praxis und Auftragsvergabe bzw. städtischer Agenden geworden zu sein, das die weit reisenden KünstlerInnen als Produktionsmaschinen für globale Inhalte positioniert. Ironischerweise scheint sich als Nebenwirkung der Ortsspezifität eine universelle künstlerische Position entwickelt zu haben. Was sich nämlich immer deutlicher manifestiert, ist eine eher standortbezogene Recherche zu – manchmal wirklich – aufschlussreichen oder dringlichen Daten über einen Ort, die genau an diesem Ort kundgetan werden müssen, bevor die KünstlerInnen an den nächsten Ort geflogen werden, um dort das Gleiche zu tun. Die Bedingungen der Zirkulation scheinen die Bedingungen der Spezifität egal welchen Orts überholt zu haben.

Darüber nachzudenken – und sicherlich auch über meine eigene Rolle in diesem Ganzen – hat mich dazu gebracht, den Versuch zu unternehmen, aus der Frage nach der Lokalisierung des Kunstwerks in einer zunehmend verzweigten und abstrakten Kultur der Kontrolle ein Konzept für den Ort des Werks zu entwickeln. Das hat etwas damit zu tun, dass das Ortskonzept durch den Begriff „schwache Lokalität“ ersetzt wurde. Lokalisierung bezieht sich darauf, wo man den Prozess des Denkens oder Handelns über ein bestimmtes Phänomen beginnt, doch findet dieser Beginn an der Rückseite eines fahrenden Zugs statt. Der Ausstellungsraum ist für More Heat than Light kein Ort, an den das Werk ganzheitlich gebunden ist, sondern ein Ort, dessen Besonderheit durch seine Betriebsstandards abgeschwächt wird: seine Bindung an ein Raster aus Protokollen des symbolischen Austauschs mit anderen Institutionen und Städten ebenso wie das physische Stromnetz, das selbst als Infrastruktur durch codierte Standards für den elektrischen Betrieb und die Umweltkontrolle geregelt wird. Das Werk verortet sich in einer Weise, die schwach genug ist, um zirkulieren zu können – zu einer gemeinnützigen Institution in San Francisco, einem Airbnb in New York oder einer Kunsthalle in Europa –, ohne jedoch die Infrastruktur dieses Orts als neutrale Stütze für autonome Objekte zu sehen, die aus ihrem Produktionskontext importiert werden. Ebenso wenig wird auf der Ebene der Produktion bzw. der Bedeutung des Werks im Hinblick auf die unmittelbaren Bedingungen des Orts ein Anspruch auf Standortspezifität erhoben.

Es geht mir vielmehr darum, dass die Infrastruktur durch die Intervention des Werks selbst reflektiert, verdichtet und abgegrenzt wird – und so andere Möglichkeitsgradienten eingeführt werden, die diese Standards durch das Umstellen des Energieverbrauchs von einem Beleuchtungs- auf ein Heizgerät neu ordnen. Energie wird in ihrer Erzeugung und ihrem Verbrauch lokalisiert, aber sie hat keinen Ort, zu dem sie richtig gehört.

Der Titel, den ich diesen Arbeiten gebe, ist Weak Local Lineaments (schwache lokale Charakterzüge). Er parodiert eine bestimmte wissenschaftliche Sprache, aber ich denke nicht, dass er einen technischen oder transparenten Zugang zum konzeptuellen Inhalt des Werks ermöglicht. Er funktioniert für mich zwar auf heuristische Weise – aber auch hier setze ich keine Transparenz bei seiner Verwendung voraus. Dies gilt umso mehr, als er an reinen Unsinn grenzt – an eine reflektierte Auseinandersetzung mit der Beschreibung als Bedingung für den Platz des Werks in der Welt. Schwache OrtsbewohnerInnen sind so schwach autonom wie sie abhängig sind von dem Ort, an dem sie tätig sind und der sie vorübergehend beherbergt. „Schwäche“ ist hier kein abwertender Begriff, sondern eine Bejahung einer möglichen Entkoppelung und Neuorientierung, die eine breitere Darstellung von Erfahrungen jenseits des Rahmens eines bestimmten Orts ermöglichen.

Die Frage, die ich mir letztlich stellen möchte, lautet: Inwiefern stößt die Arbeit an die Grenzen jener Konzepte, die sie bestimmen? Die Methodik, wenn es denn eine gibt, besteht darin, eine Struktur aufzubauen und diese gleichzeitig wieder einzureißen.

Übersetzt von Anja Schulte

[1] Bei dem Text handelt es sich um die Abschrift eines Vortrags, der ursprünglich auf dem Symposium The Whole Cool System gehalten wurde, organisiert von Simon Baier bei eikones NFS Bildkritik, Basel, 27. Mai 2016.

[2] Gemeint ist das Zusammenstellen bestimmter Artikel aus einem bereitgestellten Gesamtsortiment aufgrund von Kundenaufträgen (Anm. d. Üs.).

[3] Vgl. Bernhard Siegert, Cultural Techniques. New York 2015, S. 97.

[4] Nature Abhors a Gradient ist der Titel einer 1989 von Eric D. Schneider und J. J. Kay veröffentlichten Arbeit.

[5] Vgl. Rod Swenson, Spontaneous Order, Autocatakinetic Closure, and the Development of Space–Time, in: Annals of the New York Academy of Sciences, Vol. 901(1), 2000, S. 311–319.

[6] Vgl. Rod Swenson, Autocatakinetics, Yes – Autopoiesis, No: Steps Toward a Unified Theory of Evolutionary Ordering, in: Int. J. General Systems, Vol. 21, 1992, S. 207–228.

[7] Zitiert nach Catherine Malabou, What Should We Do With Our Brain. New York 2008, S. 41.

[8] Simon Head, Worse Than Wal-mart: Amazon’s Sick Brutality and Secret History of Intimidating Workers, Salon.com, 23. Februar 2014; https://www.salon.com/2014/02/23/worse_than_wal_mart_amazons_sick_brutality_and_secret_history_of_ruthlessly_intimidating_workers/.